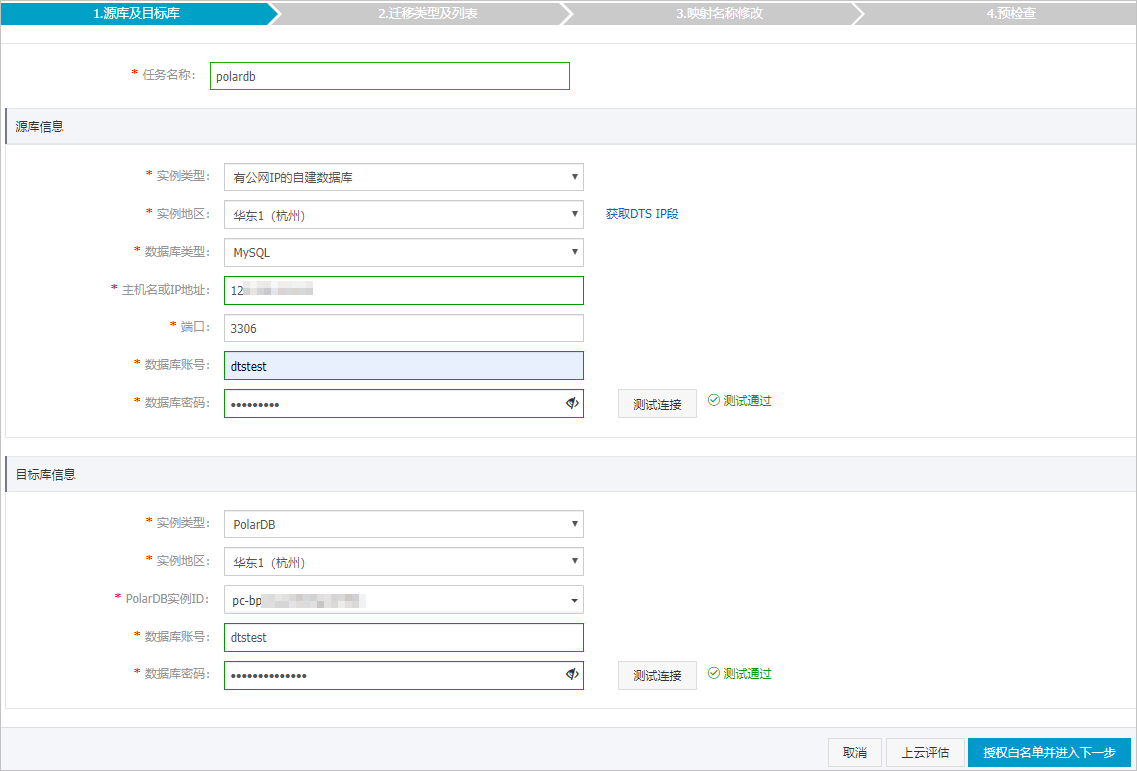

PolarDB是阿里巴巴自主研发的下一代关系型分布式云原生数据库,可完全兼容MySQL,具备简单易用、高性能、高可靠、高可用等优势。通过数据传输服务DTS(Data Transmission Service),可以帮助您将自建MySQL数据库迁移至PolarDB MySQL。

前提条件

- 自建MySQL数据库版本为5.1、5.5、5.6、5.7或8.0版本。

- 已创建目标PolarDB MySQL集群,详情请参见创建PolarDB MySQL集群。

- 如果您的MySQL数据库部署在本地,那么您需要将DTS服务器的IP地址设置为该数据库远程连接的白名单,允许其访问您的数据库。详情请参见迁移、同步或订阅本地数据库时需添加的IP白名单。

注意事项

- DTS在执行全量数据迁移时将占用源库和目标库一定的读写资源,可能会导致数据库的负载上升,在数据库性能较差、规格较低或业务量较大的情况下(例如源库有大量慢SQL、存在无主键表或目标库存在死锁等),可能会加重数据库压力,甚至导致数据库服务不可用。因此您需要在执行数据迁移前评估源库和目标库的性能,同时建议您在业务低峰期执行数据迁移(例如源库和目标库的CPU负载在30%以下)。

- 如果源数据库没有主键或唯一约束,且所有字段没有唯一性,可能会导致目标数据库中出现重复数据。

- 对于数据类型为FLOAT或DOUBLE的列,DTS会通过

ROUND(COLUMN,PRECISION)来读取该列的值。如果没有明确定义其精度,DTS对FLOAT的迁移精度为38位,对DOUBLE的迁移精度为308位,请确认迁移精度是否符合业务预期。 - 对于迁移失败的任务,DTS会触发自动恢复。在您将业务切换至目标集群前,请务必先结束或释放该任务,避免该任务被自动恢复后,导致源端数据覆盖目标集群的数据。

迁移类型介绍

支持结构迁移、全量数据迁移和增量数据迁移,详细介绍请参见

名词解释。

说明 同时使用这三种迁移类型可实现在应用不停服的情况下,平滑地完成数据库迁移。

费用说明

| 迁移类型 | 链路配置费用 | 公网流量费用 |

|---|---|---|

| 结构迁移和全量数据迁移 | 不收费。 | 通过公网将数据迁移出阿里云时将收费,详情请参见产品定价。 |

| 增量数据迁移 | 收费,详情请参见产品定价。 |

增量数据迁移阶段支持同步的SQL操作

| 操作类型 | SQL操作语句 |

|---|---|

| DML | INSERT、UPDATE、DELETE、REPLACE |

| DDL |

|

数据库账号的权限要求

| 数据库 | 结构/全量迁移 | 增量迁移 |

|---|---|---|

| 自建MySQL数据库 | SELECT权限 | REPLICATION CLIENT、REPLICATION SLAVE、SHOW VIEW和SELECT权限 |

| PolarDB集群 | 读写权限 | 读写权限 |

数据库账号创建及授权方法:

- 自建MySQL数据库请参见为自建MySQL创建账号并设置binlog。

- PolarDB集群请参见创建数据库账号。

图标将其移动至

图标将其移动至 ,查看失败详情。

,查看失败详情。